大模型的爆发是把双刃剑,ChatGPT 等智能化工具产品令人惊艳,随之而来的愈加复杂的隐私安全问题同样值得重点关注。

日前,明星大模型 ChatGPT 的开发者 OpenAI 被卷入两场诉讼中:16 人匿名指控 ChatGPT 在训练过程中收集了大量的个人数据,起诉要求 30 亿美元赔偿;两名职业作者指控 OpenAI 未经允许使用了他们的小说训练 ChatGPT,侵犯了他们的版权,同样要求赔偿 30 亿美元,目前两起诉讼均在审理中。

(资料图片仅供参考)

(资料图片仅供参考)

总部位于加州的克拉克森律师事务所表示,OpenAI 从互联网上秘密抓取了约 3000 亿字的内容,其中包括书籍、文章、网站和帖子以及未经同意的个人信息,受害用户达到数百万人。

此前,三星被曝在使用 ChatGPT 不到 20 天的时间里发生 3 起机密数据泄露,涉及三星半导体设备测量资料、产品良率等信息。把时间拨回今年一季度,香港大学等高校、顶级投行摩根大通等企业乃至意大利等国宣布禁止使用 ChatGPT ……从担心饭碗不保到忧虑隐私和版权被侵犯,生成式 AI 引发的危机感正不断升级。

大模型时代的隐私保护挑战

ChatGPT 这类大模型的进化依赖大量数据的训练,通过感应器采集数据,进行信息存储、加工,通过算力进行计算,最后形成决策机制,进行反馈。其中的数据采集环节,可能导致个人隐私、商业机密乃至国家政府层面的信息泄露与扩散,造成数据安全方面的威胁。

一篇题为的论文通过实验证明了大语言模型会记住并且泄露部分训练数据,并且越大的模型记忆力越强。此外,不仅是 OpenAI 的 GPT 模型,诸如 BERT、RoBERTa 等其他主流语言模型也纷纷中招。

上海市数据科学重点实验室主任肖仰华认为,大模型时代隐私泄露及侵权问题突出的原因主要在于大模型本身参数规模巨大、数据来源多样。生成式大模型的结果是从海量的语料中随机拼接式的概率化生成,传统上用于认定隐私侵犯的手法在大模型时代会失效,因此在侵犯识别层面就已造成困难。从保护角度而言,大模型是基于深度神经网络 Transformer 的架构,后者本质上是黑盒模型,其习得的知识和能力体系、内部运行的规律直到现在仍鲜为人知,这更使得对隐私保护很多时候无处着手。

在深度学习领域,模型的准确性与可解释性通常不可兼得:诸如神经网络、梯度增强模型等黑盒模型通常具有很高的准确性。但这类模型的内部工作机制却难以理解,也无法估计每个特征对模型预测结果的重要性,更不能理解不同特征之间的相互作用关系。而线性回归和决策树之类的白盒模型的预测能力通常是有限的,且无法对数据集内在的复杂性进行特征交互之类的建模。然而,这类简单的模型通常有更好的可解释性,内部的工作原理也更容易解释。

隐私计算如何切入大模型?

不可否认的是,大模型是一种先进生产力,是个人和企业都应该积极拥抱的,如果因为有隐私的顾虑而直接放弃对大模型的应用,某种程度上无异于因噎废食。如何正视隐私安全问题的存在,并通过相应的手段提高隐私保护的能力、积极应用大模型才是解决问题的正途。

通过多方安全计算、联邦学习、可信执行环境等技术,隐私计算起着平衡数据隐私保护与数据开放共享的作用,是数据要素安全领域的关键技术之一。

大模型时代,隐私计算技术本身的研究、发展和关注的重点也发生着改变,为让其更好地适应大模型,可以重点关注其可用性的研究。

肖仰华认为,隐私计算在大模型时代迎来了全新的机遇。诸如差分隐私、联邦学习等传统隐私计算都是在算法层面开展工作,但是算法层面工作的实施有其前提:例如,保护对象明确才可以实施差分隐私算法,合作协议清晰才可以施展一些联邦学习的策略。而海量化、参数化的大模型,给传统的基于可控、可解释、清晰的技术路线的隐私计算提出了全新的挑战。在不可控、不可编辑、难以解释的大模型环境下,传统方法如何进行发展,这看似是挑战,更多是机遇。

此外,从算法层面上升到架构层面,大模型的隐私保护还要从隔离机制角度分析。对于一些需要进行分层分级保护的个人与企业私密数据,可以建立起大模型自主学习能力和敏感数据相隔离的架构,大模型继续提供其智能,而需要保护的数据和信息依然被保存在密态数据库中,二者的相互协同也给隐私计算带来了新机遇。

中国信通院云大所大数据与区块链部门副主任闫树表示,隐私计算的各类技术路线都有与大模型应用场景适配的方式。比如在云端部署一些 TEE(可信执行环境)做训练,或在模型推理阶段用多方安全计算来提升隐私保护能力,但可能会相应牺牲一些模型的性能。

大模型不应成为脱缰野马

今年 5 月,肖仰华曾发表一篇题为《不要让大模型变成一场华丽的烟花秀》的近万字长文,主张发展大模型的同时要形成有效监管,对于隐私侵犯等破坏行为不能忽视,必须从产业的两侧加强安全底线、伦理标准与合规规范的建设:在数据源头端,加强对训练语料合规性的认证;在生成结果端,对生成内容建立起相关规范。

目前,网信办正推动《生成式人工智能服务管理办法》的出台,对生成式 AI 技术、生成内容、主体责任、数据源和数据处理等方面都作出了规定。

仅就隐私保护而言,我们需要建立起一个系统性的隐私保护防范体系:从用户角度,要建立起对大模型隐私的安全意识,要充分认识到在使用大模型过程当中,你的数据有可能被服务方所收集,从而导致隐私泄露;从提供大模型服务的厂商角度,要提升服务的规范性,给予用户充分的知情权,在用户完全授权的情况下,合理范围下收集用户相关的使用的数据,不应该超出用户授权的范围。

技术方面,在模型与应用之间还存在一层中间层,可以打乱、混淆用户的数据使用与查询记录。此外,以大模型治大模型也是一条重要路径,即靠大模型自身的能力来保护隐私,解决隐私问题。大模型可以识别出语料中有隐私侵犯嫌疑的内容,我们可以利用大模型清洗隐私数据、对其生成结果进行评估,来规避侵犯隐私问题的发生。

-

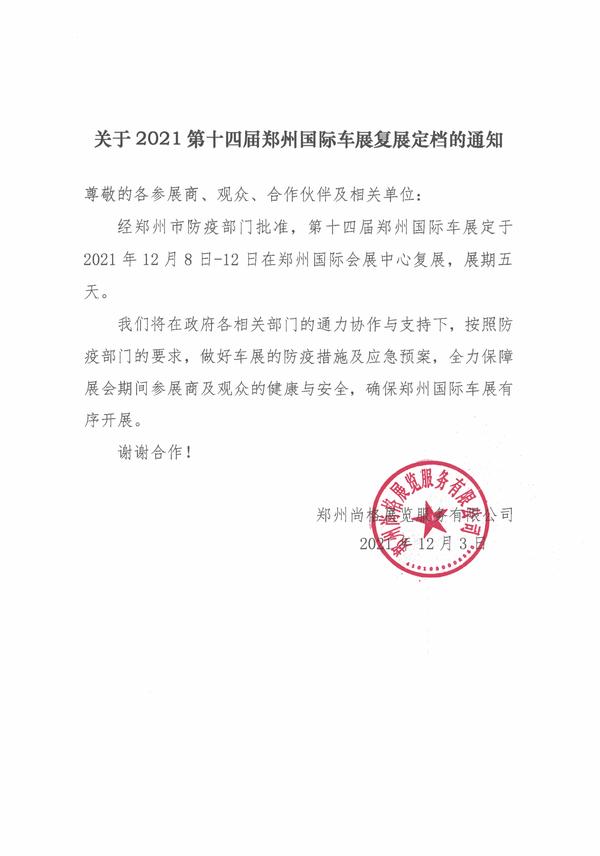

刚刚,郑州市北龙湖1宗住宅地因无人竞价流拍

头条 23-07-12

-

三门峡市发布新一轮矿产资源总体规划

头条 23-07-12

-

陈志南:引才育才用才 释放虹吸效应 | 重建河南省医学科学院

头条 23-07-12

-

首批12个河南省文化和旅游消费示范县(市、区)公布

头条 23-07-12

-

累计成交额超109亿 全国碳市场运行两年总体平稳

头条 23-07-12

-

经济日报金观平:金融政策延长适用期提振楼市信心

头条 23-07-12

-

最高补贴30万!郑州12项政策支持高校毕业生留郑就业创业

头条 23-07-12

-

何雄会见上海久奕投资管理有限公司客人

头条 23-07-12

-

起始价889万元,郑州20.5亩仓储用地挂牌出让

头条 23-07-12

-

隔夜欧美·7月12日

头条 23-07-12

-

94亿元!中联重科分拆上市大动作

头条 23-07-12

-

立方风控鸟·早报(7月12日)

头条 23-07-12

-

南方五省区电网负荷创新高!能源保供出大招

头条 23-07-12

-

今夏河南省最高用电负荷预计将达8200万千瓦

头条 23-07-12

-

非同“钒”响是如何炼成的 | 这些豫企相当潮

头条 23-07-12

-

上半年河南省新增境内外上市公司5家,上市公司总数达160家

头条 23-07-12

-

上汽乘用车郑州基地第150万辆整车下线

头条 23-07-12

-

证监会出手!闻泰科技控股股东及实控人被立案调查

头条 23-07-11

-

明起,国有六大行4000亿现金分红要来了

头条 23-07-11

-

新田商业启动郑州国贸店“大修”,花园路商圈将进入四强竞技时代

头条 23-07-11

-

传闻蚂蚁金服要成立金融IT软件板块?恒生电子回应

头条 23-07-11

-

河南省政府新任免一批干部

头条 23-07-11

-

立方风控鸟·晚报(7月11日)

头条 23-07-11

-

惠及8712.2万人次,河南上半年发放惠民惠农财政补贴252.7亿元

头条 23-07-11

-

监管摸底银行贷款直播 多家银行已排查完毕

头条 23-07-11

-

光力科技:预计上半年净利润4429.80万元~5315.76万元

头条 23-07-11

-

郑州银行副董事长、董秘夏华辞职,提名张骅为执行董事候选人

头条 23-07-11

-

郑州地铁多举措应对汛期强降雨,保障乘客出行安全

头条 23-07-11

-

小米“定制小爱”功能停运下线,语音助手如何成为好“助手”?

头条 23-07-11

-

林州重机:上半年净利预增3747%-5008%

头条 23-07-11

-

40℃+高温一路狂飙!催热郑州的“高温经济”

头条 23-07-11

-

赵淑红:做“耐心资本”,助推河南省产业园区高质量发展 | 聚焦专题议政②

头条 23-07-11

-

中国社科院金融所报告:建议阶段性提高财政赤字率,继续降息

头条 23-07-11

-

央行发布上半年金融数据报告:M1增速3.1%,M2增速11.3%

头条 23-07-11

-

央行:6月末社融规模存量365.45万亿元,同比增长9%

头条 23-07-11

-

中通快递全资收购支付牌照,恒大万通支付获批更名中通支付

头条 23-07-11

-

金融支持房地产部分政策延期,影响几何?专家解读→

头条 23-07-11

-

总投资2.4亿!风语筑联合中标开封黄河悬河文化展示园展陈工程

头条 23-07-11

-

泡泡玛特首个线下主题乐园或于9月份正式开业

头条 23-07-11

-

河南启动2023年智能制造标杆企业遴选,各地名额公布

头条 23-07-11

-

中国国家铁路集团拟发行200亿元建设债 | 附项目清单

头条 23-07-11

-

上海微反光碗唯一供应商,百合光学发力纳米级光刻机光源突破 | 传感半导体·助力新河南

头条 23-07-11

-

洛阳鑫通经济发展投资公司拟发行5亿公司债,用于安置房建设等

头条 23-07-11

-

格力旗下城市发展公司增资至46亿

头条 23-07-11

-

河南省大气污染防治攻坚座谈会在信阳市举行

头条 23-07-11

-

首超2亿元!新开源预计今年上半年盈利创历史最佳

头条 23-07-11

-

中原内配:预计上半年净利润同比增长86.73%~108.07%

头条 23-07-11

-

暴雨黄色预警!郑州市主城区降水量将达50毫米以上

头条 23-07-11

-

国家发改委印发 《承接产业转移示范区管理办法》

头条 23-07-11

-

拟出资5亿参与新华联破产重整,联创股份收关注函

头条 23-07-11

-

许昌市投资集团完成发行10亿元短融,利率利率4.35%

头条 23-07-11

-

便民就医少跑腿 河南移动打造院内3D智能导航服务

头条 23-07-11

-

民生银行郑州分行社区金融十周年:全面构建社区金融管家服务体系,提供多元化金融服务

头条 23-07-11

-

牛皮吹破!南方精工互动平台“讲故事”,董事长、董秘遭监管警示

头条 23-07-11

-

涉及高考招生多个环节!这五类骗局请小心

头条 23-07-11

- 数百万人的隐私被用于训练 ChatGPT?大模2023-07-12

- 文艺暑假好去处!在文化广场感受剧场魅力2023-07-12

- 防范冒用金融监管名义实施诈骗!国家金融监2023-07-12

- Keep 港交所上市,奖牌之后有何底牌?2023-07-12

- 我市全社会用电负荷和单日用电量创历史新高2023-07-12

- 飞机遇到的“晴空颠簸”到底是什么?是小概2023-07-12

- 向往的“饭”不一定好吃2023-07-12

- 梅花创投吴世春:通用大模型可能只有两三家2023-07-12

- 刚刚,郑州市北龙湖1宗住宅地因无人竞价流2023-07-12

- 三门峡市发布新一轮矿产资源总体规划2023-07-12

- 陈志南:引才育才用才 释放虹吸效应 | 2023-07-12

- 首批12个河南省文化和旅游消费示范县(市、2023-07-12

- 累计成交额超109亿 全国碳市场运行两年总2023-07-12

- 大同考古纪实展在大同市雕塑博物馆开展2023-07-12

- 东方证券新任命首席研究总监和首席投资官 2023-07-12

- 甘肃发布省级暴雨蓝色预警 两地发布暴雨红2023-07-12

- 工信部:上半年我国造船三大指标全面增长 2023-07-12

- 紧急状态!全面进入!陕西最新预警!2023-07-12

- 朱雀二号遥二运载火箭发射成功2023-07-12

- 形成发展合力,营造良好生态,重庆—— 2023-07-12

- 黑龙江青龙山灌区—— 三江奔流处 万顷2023-07-12

- 四川多地受强降雨影响 已转移群众40596人2023-07-12

- 全球首枚!朱雀二号液氧甲烷火箭成功发射2023-07-12

- 防范冒用金融监管名义实施诈骗!国家金融监2023-07-12

- 及时下线“幽灵外卖”2023-07-12

- 我驻欧盟使团正告北约:坚决反对北约“东进2023-07-12

- 我省境内外上市公司达160家 上半年境内豫2023-07-12

- 国内油价调价窗口12日开启,或现今年首次连2023-07-12

- 注意防范!今日河南全省阴天 局部有雷暴大2023-07-12

- 一揽子成长方案让好老师不断涌现2023-07-12